はじめに

AIの活用はさまざまな場面に広がってきており、AIが私たちの生活をより豊かにすることが期待されています。しかし、AIチャットボットが差別的な発言を繰り返してサービスが停止されるケースなど、AIの問題点が顕在化する場面も散見されます。このような問題点に対処するために、AIガバナンスに関する議論が世界各国でなされています。

AIがもたらす可能性のある危険性を抑止するために、AIの開発者や利用者が守るべき原則として定められる「AI原則」についてはコンセンサスが得られつつありますが、“AI原則を具体的にどのように実践していけばよいか”という点は、依然として不明確な状況と考えられます。

そこで本稿では、前後編の2回に分けて、AI原則をより一歩進めた、「AIガバナンスの実践のための指針」を示したいと考えています。前編である今回は、

・ AIガバナンスの問題点

・ 海外での議論の状況

・ AIガバナンスに関するアプローチ

などを整理し、後編では、AI原則を具体的に実践する“AIガバナンスのあり方”について検討します。

AIガバナンスとは

AIガバナンスとは?

経済産業省が2021年7月9日に公表した「我が国のAIガバナンスの在り方 ver1.1」によると、AIガバナンスとは、

AIの利活用によって生じるリスクをステークホルダーにとって受容可能な水準で管理しつつ、そこからもたらされる正のインパクトを最大化することを目的とする、ステークホルダーによる技術的、組織的、及び社会的システムの設計及び運用

と定義されています。

AIガバナンスのポイントは、「AIの利活用によって生じるリスク」を、受容可能な水準で管理することにあります。

AIガバナンスはなぜ必要か?

「AIの利活用によって生じるリスク」は、特にAIが自然人の一定の個人的側面を評価するAIプロファイリング注1において、主に以下の三つの権利に対して問題となります。

まず、第1に、プライバシー権注2に関する問題があります。大量のデータにより個人を評価していくAIプロファイリングの結果は、仮に真実ではないとしても、一般の人からすると真実らしく受け取られる可能性があります。そのような“真実らしい”結果は、プライバシーの侵害と考えることができます。

第2に、差別に関する問題があります。ある外国企業では、採用活動にAIを活用して入社応募を行った人をフィルタリングしていたところ、AIが男性を優遇していたことが判明しました。これは、従前の採用者に占める男性の割合が高かったことから、AIが女性よりも男性を高く評価する結果に至ったものとされています。このように、AIのアウトプットは差別が問題となる場合があります注3。

第3に、内心の自由に関する問題があります。プロファイリングの結果に基づき、当該個人に提供する情報を恣意的に取捨選択することで、当該自然人の行動をコントロールしてしまうリスクがあります。このようなコントロールは、アメリカ合衆国の大統領選挙において利用され、問題となったことがあり、議会制民主主義との関係でも大きな論点となりえます。

このようなAIの利活用によって生じるリスクを、ガバナンスによって管理することが必要となります。

AI原則とは

AIの利活用を推進するために、ステークホルダーが留意すべき原則を一般的に「AI原則」と呼びます。

AI原則の内容については、国際的におおむねコンセンサスが形成されており注4、日本を含む複数国間で合意したOECDのAI原則は図表1のとおりです注5。OECDのAI原則は法的拘束力を有しませんが、AIシステムの設計者、運用者にその適切な利用に責任を持たせる際の指針を与えることを目的としています注6。

図表1 AI原則の概要

|

No. |

項目 |

概要 |

|

1 |

包括的な成長、持続可能な開発および幸福 |

AIは、包摂的成長と持続可能な発展、暮らしよさを促進することで、人々と地球環境に利益をもたらすものでなければならない。 |

|

2 |

人間中心の価値観および公平性 |

AIシステムは、法の支配、人権、民主主義の価値、多様性を尊重するように設計され、また公平公正な社会を確保するために適切な対策がとれる(たとえば、必要に応じて人的介入ができる)ようにすべきである。 |

|

3 |

透明性および説明可能性 |

AIシステムについて、人々がどのようなときにそれと関わり、結果の正当性を批判できるのかを理解できるようにするために、透明性を確保し、責任ある情報開示を行うべきである。 |

|

4 |

頑健性、セキュリティおよび安全性 |

AIシステムは、その存続期間中は、健全で安定した安全な方法で機能させるべきで、起こりうるリスクを常に評価、管理すべきである。 |

|

5 |

アカウンタビリティ |

AIシステムの開発、普及、運用に携わる組織および個人は、上記の原則に則って、その正常化に責任を負うべきである。 |

AIガバナンスをめぐる各国の動向

Ⅲで述べたように、AI原則の国際的なコンセンサスが得られたことから、現在は、各国においてAI原則を社会で実現するためのガバナンスの議論が行われています。

以下では、各国の議論の状況を見ていきます。

EU

EUでは、Artificial Intelligence Actのドラフト(以下「AI規則案」といいます)が2021年4月21日に公開され、議論が重ねられています。AI規則案の大きな特徴としては、リスクベースアプローチが採用された点にあります。具体的には、AIシステムを、

・ 許容できないリスク

・ ハイリスク

・ 限定リスク

・ 最小限リスク

に区分したうえで、区分に応じた義務を課しています(図表2参照)。

図表2 AI規則案のリスク類型とその概要

|

類型 |

該当するAIシステム概要 |

主な義務 |

|

許容できないリスク |

・ 年齢、身体的・精神的障害などによる集団に属する人の身体的・精神的損害を与える方法で、当該人の行動を著しく歪める目的のもの ・ 公的機関または公的機関のために行われる、社会行動などにより、自然人の信頼性を評価・分類するAIシステム など |

・ 禁止(5条) |

|

ハイリスク |

・ 自然人の遠隔生体識別 ・ 採用選考目的での使用、個人の業務パフォーマンスの評価等 ・ 公的給付の決定の際の適格性評価等 ・ 自然人の犯罪・再犯リスク評価等 など |

・ リスク管理システムの構築(9条) ・ データガバナンス(10条) ・ 人間による監視(14条) など |

|

限定リスク |

・ 自然人との対話を目的としたAIシステム ・ バイオメトリクス認証 ・ いわゆる“ディープフェイク”を生成・操作するAIシステム |

・ 透明性確保(52条) |

|

最小リスク |

・ 他の類型に該当しないAIシステム |

特になし |

米国

米国ホワイトハウスの科学技術政策局は、2022年10月4日に、「AI権利章典のための青写真」(以下「青写真」といいます)を発表しました注7。青写真は、米国市民の公的な管理、機械や極めて重要なリソースやサービスへのアクセスに重大なインパクトをもたらしうる自動化システム(Automated System)を対象としています注8。青写真は法的拘束力を有しないものの、システムの設計、使用、配備する際に考慮すべき五つの原則として、

・ 安全で効果的なシステム

・ アルゴリズムによる差別からの保護

・ データプライバシー

・ 通知と説明

・ 人間による代替、考慮、予備的措置

を示しています。さらに、技術の設計段階において原則を具体化するための詳細なステップを記載した「原則から実践へ」というハンドブックが付属されています。

また、国立標準技術研究所がArtificial Intelligence Risk Management Frameworkを公表するなど注9、米国でもさまざまな動きが見受けられます。現時点では、これらの動きと青写真との関係は明確になっていません注10。

シンガポール

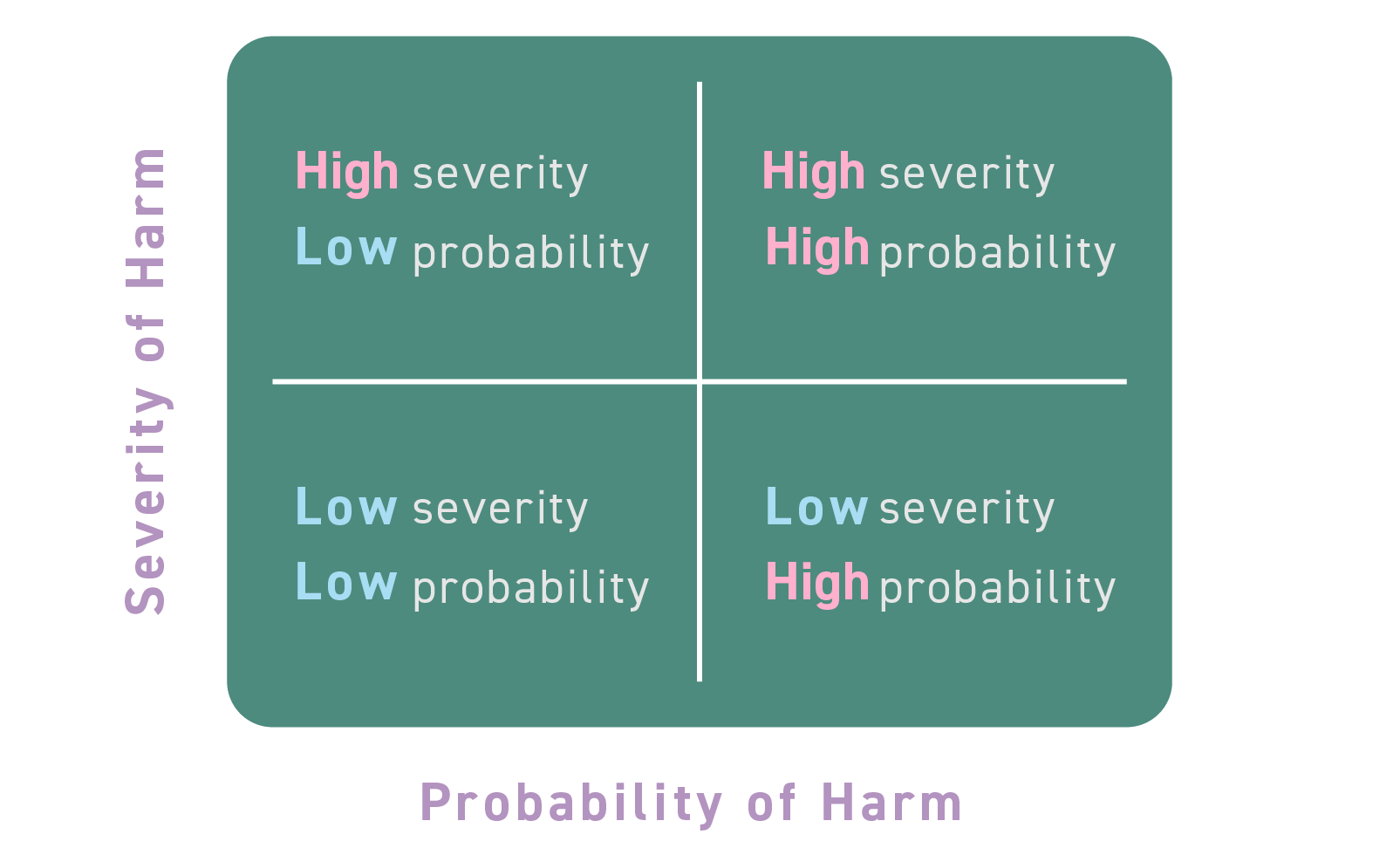

シンガポールの情報通信メディア開発庁および個人データ保護委員会は、2020年1月21日に、第2版となるModel Artificial intelligence Governance Framework(以下「AIフレームワーク」といいます)を公表しています。AIフレームワークは、法的拘束力を有するものではなく、また具体例を多数紹介することで実務的な情報を提供しているという特徴を有します。AIフレームワークではリスクベースアプローチを採用し、インシデントが発生したときの害悪の深刻さとその発生可能性によりリスクを分類し(図表3参照)、それに応じて人間が関与する度合いを決定することとしています注11。

図表3 AIフレームワークによるリスク分類

出典:シンガポール個人データ保護委員会“MODEL ARTIFICIAL INTELLIGENCE GOVERNANCE FRAMEWORK SECOND EDITION”31頁を基に作成。

また、シンガポールの情報通信メディア開発庁および個人データ保護委員会は、2022年5月25日に、世界で初めてAIガバナンステストフレームワーク・ツールキットであるVerify A.Iを公表しました注12。Verify A.Iは技術テストとプロセスチェックを組み合わせることで、AIシステムの信頼性をテストし、企業とステークホルダー間の透明性を促進することを目的としています注13。

日本

経済産業省は、2021年7月9日に、「我が国のAIガバナンスの在り方 ver1.1」を公表しました。ここでは、国内外の動向を整理したうえで、我が国のAIガバナンスの在り方を検討しています。その中で、AIガバナンスにはリスクベースアプローチが産業界や消費者団体からも支持されていることが説明されており、また、AI原則の具体化のためには、中間的かつ実践的なガイドラインが必要であると説明されています。

それを受けて、経済産業省は、2022年1月28日に、「AI原則実践のためのガバナンス・ガイドライン Ver.1.1」を公表しました。このガイドラインに法的拘束力はなく、実施すべき行動目標、実践例、乖離評価等を掲載し、AI原則の実践に関するステークホルダーの共通認識の形成を通じて、各社の自主的な取り組みを後押しすることが期待されています。

小括

以上のとおり、いずれの国もリスクに応じて義務の程度を変化させるリスクベースアプローチを採用していると考えられます注14。EUは、法的拘束力を持ったAI規則案について議論を進めていますが、シンガポール、日本については法律(ハードロー)ではなく、ガイドラインなどのソフトローでのルール形成を検討しています。ソフトローは、民間で自主的に定められているガイドラインのほか、行政が示す法解釈等も含む広い概念ですが注15、法律(ハードロー)の制定や改正といった時間のかかる手続なしに、柔軟に規範を定立・変更することができるという利点があります。そのため、後述するような、アジャイルガバナンスとの親和性が高いといえます。

AIガバナンスのキーワード―アジャイルガバナンス、リスクベースアプローチ、原理原則アプローチ

AIガバナンスの特徴

AIをはじめとする近時のテクノロジーは進歩が極めて速く、それに伴い社会の変化も急速であることから、「国家が法で一律に行為義務を定め、それに従うことでガバナンスの目的が達成される」という従来型のガバナンスモデルは維持しがたくなってきています。そこで、国家がルール形成する“従来型”のモデルから、ゴールをステークホルダーが共有し、そのゴールに向けて柔軟かつ臨機応変なガバナンスを行っていくというアプローチが必要と考えられています。その方法として“アジャイルガバナンス”があります。

また、ガバナンスを構築するにあたっては、各企業の扱うAIの特徴や、組織形態に応じた個別具体性が必要となります。個別具体的なガバナンスを構築する際に、「何を、どこまでやるべきか」という問いへの指針として、“リスクベースアプローチ”や“原理原則アプローチ”があります。

以下では、それぞれのキーワードをもう少し掘り下げて説明していきます。

アジャイルガバナンス

(1) アジャイルガバナンスとは

アジャイルガバナンスには一義的な定義があるわけではありませんが注16、主な特徴として、一度構築したガバナンスを継続的に評価し改善していくことが挙げられます。

上述のとおり、柔軟かつ臨機応変なガバナンスが求められるAIガバナンスにおいて、アジャイルガバナンスが必要とされます。

(2) アジャイルガバナンスの進め方

それでは、アジャイルガバナンスはどのように進めるのがよいでしょうか。さまざまなアプローチがありうるところだと思われますが、一つのアプローチとしては、具体的なプロジェクトを複数検討し(可能であれば、プロジェクトの概要が異なるものが望ましい)、そこから共通項や検討事項を整理するなど抽象化していく演繹的なアプローチが考えられます。

複数のプロジェクトをベースとすることにより、さまざまな視点での整理が可能となります。また、自社で進めているプロジェクトをベースにすることで、自社のビジネス、組織形態などに沿ったものとなることが期待できます。なお、自社で十分な案件がない場合には、各国が公表している事例集を活用することが考えられます。

リスクベースアプローチ

リスクベースアプローチは、規制の程度をリスクの大きさに対応させるべきという考えをいいます注17。これは、一口に“AI”といってもさまざまな利用場面があり、これに一律に規律を及ぼしてしまうと、AIガバナンスに過大なコストを生じさせ、AIの利活用の障害となりうるため、これを回避するためのアプローチです。

しかし、「どのようにリスクを判断するか」についてはさまざまなアプローチがあり、難しい問題の一つとなっています。具体的には、リスクの大きさの区分に関するアプローチや、用途に基づき区分するアプローチ(物理的なリスクと社会的なリスクに区分するアプローチなど)などがあります注18。

原理原則アプローチ(プリンシプルベースアプローチ)

また、当局が事前にルールを設定するアプローチ(ルールベースアプローチ)ではなく、抽象的で大掴みな「原則(プリンシプル)」について、関係者がその趣旨・精神を確認し、互いに共有したうえで、各自、自らの活動が、形式的な文言・記載ではなく、その趣旨・精神に照らして真に適切か否かを判断するアプローチを、一般的に、「原理原則アプローチ(プリンシプルベースアプローチ)」といいます注19。

AIガバナンスにおいては、AI原則が「原則(プリンシプル)」の大枠を定めたものに該当します。しかし、原則はあくまで“大枠”であり、原則を定めただけではガバナンスシステムは機能しません。AIの利活用において問題となりうる

・ プライバシー権

・ 平等

・ 内心の自由

などの権利利益なども「原則(プリンシプル)」として尊重したガバナンスシステムを設計することが重要ですし、また必須であるといえます。

事例に基づく検討

ここで、事例に基づく検討をしてみたいと思います。具体的な検討については次回で説明したいと思います。

【事例】

A社は、各企業の情報など就活に役立つ情報提供を行うポータルサイトを運営し、就活生が当該ポータルサイトで

・ どのような経路で

・ どのような情報を

・ どの程度

見ているかというようなポータルサイト上の“行動履歴データ”を保有している。この行動履歴データと、過去の内定辞退者の行動履歴データとをAIで分析することで、内定辞退率をスコアリングすることとした。当該内定辞退率は、契約した企業に就活生の氏名とともに提供するサービスを提供することとした。

【設問】

あなたがA社のAIガバナンス担当者であると仮定して、上記事例をどのように判断するか(A社は個人情報保護法で求められる対応は実施することは前提とする。)。

設問① 本プロジェクトの実施は可能と判断するか。

設問②-A ①で「可能ではない」と判断する場合、どのように社内で説明するか。

設問②-B ①で「可能である」と判断する場合、どのようなガバナンス体制の構築や対応を行うか。

- EU一般データ保護規則(General Data Protection Regulation。以下「GDPR」といいます)はプロファイリングを、「自然人と関連する一定の個人的側面を評価するための、特に、当該自然人の業務遂行能力、経済状態、健康、個人的嗜好、興味関心、信頼性、行動、位置及び移動に関する側面を分析又は予測するための、個人データの利用によって構成される、あらゆる形式の、個人データの自動的な取扱いを意味する」と定義づけています(GDPR 4条(4)。個人情報保護委員会の仮日本語訳参照)。カリフォルニア州プライバシー権法(California Privacy Rights Act。以下「CPRA」といいます)も同様の定義を設けています(CPRA 1798.149条(z))。[↩]

- プライバシー権は、伝統的に、「個人が道徳的自律の存在として、自ら善であると判断する目的を追求して、他者とコミュニケートし、自己の存在にかかわる情報を「どの範囲で開示し利用させるか」を決める権利」(自己情報コントロール権)と考えられてきています(佐藤幸治『日本国憲法論〔第2版〕』(成文堂、2021)203頁)。現在はプライバシー権に関してさまざまな議論がなされています。[↩]

- こうしたAIプロファイリングによる低評価に付きまとわれ、社会的・経済的に排除され続ける人が発生する可能性が指摘されていますが、このような社会的・経済的に排除され続ける人々が集まる仮想的スラムを「バーチャルスラム」と呼ぶことがあります。[↩]

- 経済産業省「我が国のAIガバナンスの在り方 ver1.1」(2021年7月9日)9頁。[↩]

- OECD “Recommendation of the Counsil on Artificial Intelligence”。なお、総務省による非公式翻訳として「人工知能に関する理事会勧告」があります。[↩]

- OECD東京センターニュースルーム「42カ国がOECDの人工知能に関する新原則を採択」。[↩]

- THE WHITE HOUSE “Blueprint for an AI Bill of Rights: A Vision for Protecting Our Civil Rights in the Algorithmic Age”(2022年10月4日)。[↩]

- THE WHITE HOUSE “Blueprint for an AI Bill of Rights ― Making Automated Systems Work For The American People”。[↩]

- NIST “NIST Risk Management Framework Aims to Improve Trustworthiness of Artificial Intelligence”(2023年1月26日)。[↩]

- WORLD ECONOMIC FORLUM “Understanding the US 'AI Bill of Rights' - and how it can help keep AI Accountable”(2022年10月14日)。[↩]

- 人間のAIアウトプットへの関与の方法としては、

・ 人間がAIアウトプットを承認しなければならない(Human-in-the-loop)。

・ 人間が関与する必要がない(Human-out-of-the-loop)。

・ 人間がAIアウトプットを監視・監督しなければならない(Human-over-the-loop/Human-on-the-loop)。

とに区別されています。「Human-out-of-the-loop」の例としては、行動履歴に基づき自動で商品のレコメンドを行うAIが挙げられています。[↩] - Personal Data Protection Committee Singapore “Singapore’s Approach to AI Governance”。[↩]

- Infocomm Media Development Authority “Singapore launches world’s first AI testing framework and toolkit to promote transparency; Invites companies to pilot and contribute to international standards development”(2022年5月25日)。[↩]

- 米国の青写真では、リスクベースアプローチを採用していることを示す直接的な説明はありませんが、「通知と説明」などにおいてリスクに応じた説明がなされており、リスクベースアプローチに整合的な立場と考えられます。[↩]

- 内閣府知的財産戦略推進事務局「第6回構想委員会(本会合) 配布資料 資料3 知財事務局説明資料(ソフトロー)」(2021年4月16日)1頁。[↩]

- 経済産業省が2021年7月に公表した「Governance Innovation Ver.2 アジャイル・ガバナンスのデザインと実装に向けて」において、アジャイルガバナンスを、「政府、企業、個人・コミュニティといった様々なステークホルダーが、自らの置かれた社会的状況を継続的に分析し、目指すゴールを設定した上で、それを実現するためのシステムや法規制、市場、インフラといった様々なガバナンスシステムをデザインし、その結果を対話に基づき継続的に評価し改善していくモデル」(v頁)や、「様々な社会システムにおいて、「環境・リスク分析」「ゴール設定」「システムデザイン」「運用」「評価」「改善」といったサイクルを、マルチステークホルダーで継続的かつ高速に回転させていくガバナンスモデル」(49頁)と説明しています。[↩]

- 経済産業省・前掲注4・6頁。[↩]

- 経済産業省・前掲注4・7頁。[↩]

- スチュワードシップ・コードに関する有識者検討会(令和元年度)「「責任ある機関投資家」の諸原則<<日本版スチュワードシップ・コード>>~投資と対話を通じて企業の持続的成長を促すために~」(2020年3月24日)8頁および「金融規制の質的向上:ルール準拠とプリンシプル準拠」(日本経済新聞社主催シンポジウム「活力ある法化社会へ」(平成19年9月12日)における金融庁長官(当時)佐藤隆文氏講演)を参照。[↩]

渡邊 満久

AsiaWise Digital Consulting & Advocacy株式会社 取締役

AsiaWise法律事務所 パートナー弁護士

2013年都内法律事務所で業務開始し、主に企業の紛争解決や裁判業務、倒産・M&A・労働等をはじめとする企業法務全般を取り扱う。2018年頃から情報法分野を取り扱うようになるが、当時の弁護士の業務形態・サポート態様での企業へのデータ利活用推進支援に限界を感じ、2019年AsiaWise法律事務所に加入。以降は個人データに限らずデータ全般を利用したビジネス・プロジェクト組成、AI利用に係る法的問題点の解決、クロスボーダーでのデータ利活用等について、課題解決に取り組む。2021年AsiaWise Digital Consulting & Advocacy設立に尽力。

田中 陽介

AsiaWise Digital Consulting & Advocacy株式会社 取締役

2006年外資系企業知財部で勤務開始し、主に通信・エレクトロニクス分野の特許を取り扱う。2010年より東南アジア・南アジアを拠点として多国籍企業のアジア新興国での知財権利化、権利行使に加え、現地スタートアップ企業の知財面を支援。2019年AsiaWise Groupに加入。クロスボーダーでのデータ利活用に加え、通信関連規制、AIやOSSの利用など、技術と法律の両面からの理解が必要なさまざまなプロジェクトにおいて課題解決に取り組む。

西尾 暢之

AsiaWise法律事務所 弁護士

2017年都内の大手税理士法人で勤務開始し、2019年から都内法律事務所にて勤務。国際税務、税務紛争、M&A、海外法令調査などの業務に加え、リーガルファンクションコンサルティングといった法務部のDXに関するコンサルティング業務の経験を有する。2021年AsiaWise法律事務所に加入。現在は主にDXプロジェクトにおけるデータ・情報利活用支援を行う。